2025/12/18

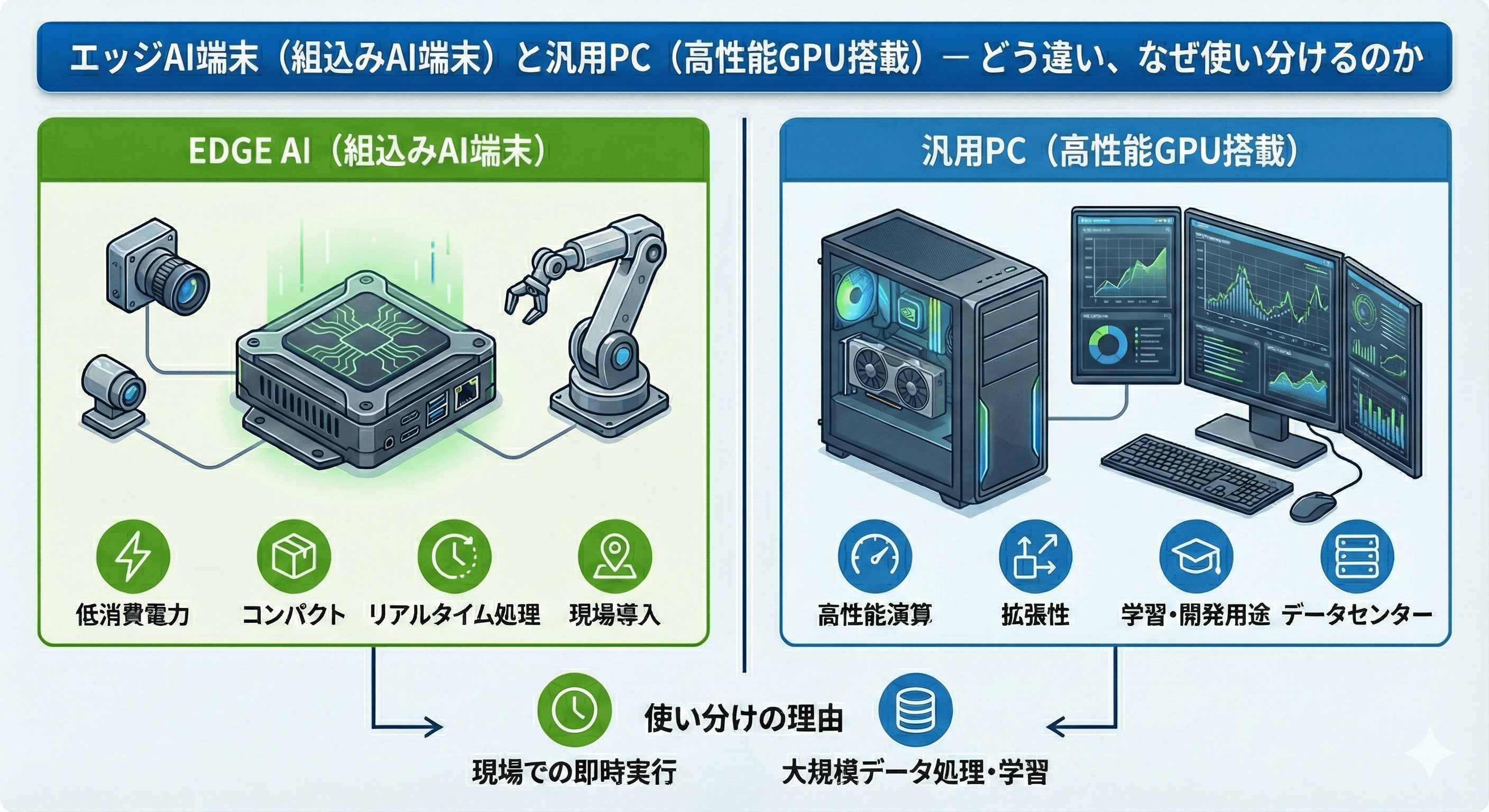

エッジAI端末(Jetson搭載)と汎用PC(RTX搭載)— どう違い、なぜ使い分けるのか

エッジAI端末と一般的な汎用PC(デスクトップPC/ノートPC)は、どちらも広い意味では「コンピュータ」です。しかし、設計思想や使われる環境、得意とする用途が大きく異なります。本記事では、映像AIでよく名前が挙がるNVIDIAの「Jetson」と「RTX」を例に違い(向き・不向き)を整理したうえで、なぜ“エッジAI端末”が選ばれるのかを解説します。

目次

まず整理:エッジAI端末も「PCの一種」

JetsonとRTXの違い(向き・不向き)

RTX搭載の汎用PCが得意なこと(+価格感)

それでもエッジAI端末が必要になる理由

RTX搭載PCで代用すると起きやすい課題

Zenmov×EDGEMATRIXで「運用が簡単」と言える理由

まとめ

補足:なぜエッジAIでNVIDIAがよく使われるのか(CUDAエコシステム/CUDA Tile)

1. まず整理:エッジAI端末も「PCの一種」

エッジAI端末(エッジPC、産業用AI端末など)は、入力(カメラ映像・センサー)→処理(AI推論)→出力(通知・制御・保存)という点で、コンピュータの基本構造は汎用PCと同じです。ただし、一般に「PC」と言うとオフィスや家庭で使うデスクトップPC/ノートPCを指すことが多いため、本記事では区別のために「汎用PC(RTX搭載PC)」と「エッジAI端末(Jetson搭載端末)」と呼び分けます。

簡単に整理すると、

汎用PC(RTX搭載PC): 安定した室内環境で使う前提の、幅広い用途に対応できる“高性能な一般PC“

エッジAI端末(Jetson搭載端末): 現場向けに最適化された“用途特化型PC”

2. JetsonとRTXの違い

ここでは、映像解析の現場でよく名前が挙がるNVIDIA製品を取り上げます。Jetsonは「現場に置く前提の小型コンピュータ」、RTXは「PCやサーバに挿す高性能GPUカード」です。

Jetson(エッジ向け)

ARM CPU+GPUを統合したエッジ向けプラットフォーム

小型・省電力・連続稼働を重視(現場設置を想定)

カメラやセンサーと組み合わせて、リアルタイム推論を現場側で完結しやすい

耐環境性(防塵・耐振動など)を持つ端末に組み込まれることが多い

RTX(汎用PC/サーバ向け)

主にPC/サーバに搭載するディスクリートGPU(カード)

圧倒的なGPU性能と価格競争力が魅力(用途が広い)

PC作業・開発環境・検証など“汎用用途”も同居できる

ただし、設置環境は基本的に室内(電源・空調・筐体スペースが前提)

3. RTX搭載の汎用PCが得意なこと(+価格感)

結論として、RTX搭載の汎用PCは「性能」と「価格」の面で非常に魅力的です。特にPoC(お試し検証)や、空調の効いたサーバ室・事務所内で運用できる環境では、現実的な選択肢になります。

性能:高いGPU性能で、映像解析から大規模モデルの検証まで幅広く対応しやすい

柔軟性:汎用OS(Windows/Linux等)で、用途に応じてソフトを自由に構成できる

コスト:同等クラスの推論性能を狙う場合、構成次第では“コスパが良い”ケースもある

通常のPC作業(開発、編集、分析など)も同じ1台でこなせる

〈価格感の目安〉※2025年時点

価格はGPU世代、CPUやメモリ、筐体(産業用か)、入手経路(量販/BTO/業務向け)で大きく変わります。あくまで目安として、国内で見かけるレンジを整理します。

カテゴリ | 価格帯の目安(新品) | 補足 |

RTX搭載のデスクトップPC | 約12万〜35万円台が中心(上位は50万円超も) | BTO/量販で幅広い。GPU世代と周辺構成で変動 |

Jetson搭載のエッジPC(一般的な小型機) | 約20万〜40万円前後 | 小型・省電力を重視した構成が多い |

Jetson搭載の産業用・堅牢エッジPC | 約30万〜80万円超もあり得る | 防塵・耐振動など“筐体要件”で上振れしやすい |

「RTX搭載PCのほうが高性能で安価に見える」ことは珍しくありません。それでもエッジAI端末が選ばれるのは、次章の“運用条件”が大きく効いてくるためです。

4. それでもエッジAI端末が必要になる理由

AIを“動かすだけ”なら汎用PCでも可能です。たとえば、カメラ映像を読み込んで「車が写っている」「人が通った」程度の検知は、事務所のPCでも処理できます。

一方で、エッジAIが本当に価値を発揮するのは、次のような現場条件がそろうときです。

駐車場、工場、店舗、道路、施設の出入口など“現場”に設置する

24時間365日、止まらずに動き続けることが求められる

暑さ・寒さ・ホコリ・振動など、環境が過酷

電源や設置スペースに制約がある(省電力・小型が重要)

これらを満たすために生まれたのが、エッジAI端末(エッジPC)です。エッジ端末もPCですが、「AIでよく使う部分(GPUなど)」を特化し、現場で不要になりがちな要素を最小化することで、“推論を回し続ける”コストパフォーマンスと運用性を高めています。

次に、JetsonとRTXを見比べると、違いがより明確になります。

5. RTX搭載PCで代用すると起きやすい課題

「現場でJetsonの代わりにRTX搭載の汎用PCを置けばいいのでは?」という発想は自然です。ただ、エッジAIが担う“現場要件”を満たそうとすると、主に次の課題が出やすくなります。

① 運用コストと非効率の増大

電力コストが上がりやすい(台数が増えるほど影響が大きい)

発熱が大きく、冷却・防塵・騒音対策が必要になりやすい

屋外・車載など、電源やスペースに制約がある場所では設置自体が難しくなる

② リアルタイム性・信頼性の確保が難しい

粉塵・振動・温度変化などで故障リスクが上がる(止まると現場が困る)

OS更新や再起動など、連続稼働の設計・監視を自前で作り込む必要がある

現場ごとの配線・設置・遠隔監視・復旧手順など、保守設計が増える

まとめると、RTX搭載PCは高い処理性能を備える一方で、現場で24時間365日止めずに稼働させることは難しいです。また、運用設計から保守・維持までを一から構築する必要があり、負担が大きくなりがちです。こうした負担を“製品として”吸収し、現場導入を容易にする点に、エッジAI端末の価値があります。

6. Zenmov×EDGEMATRIXで「運用が簡単」と言える理由

ここまでで「RTXは高性能で安いことも多いのに、なぜエッジ端末が必要なのか?」という疑問がより具体化したと思います。運用面まで含めて考えると、エッジAI端末は“AIの現場運用を前提にパッケージ化されたPC”であり、導入後の負担が大きく変わります。

Zenmovが取り扱うJetsonベースのエッジAI端末では、次のような管理がダッシュボード中心で行えます。

端末の一括管理:端末一覧、稼働状態(オンライン/オフライン)、温度やリソース使用率などのヘルスチェック

AIアプリ/モデルの配布:推論アプリの導入・更新、設定配布、再起動などを遠隔で実施

カメラ/入力の管理:ストリーム設定、解析対象領域(ROI)や検知条件の設定

アラート/ログ:検知イベントの履歴、ログの収集、アラート通知の設定

運用の省力化:現場ごとにバラバラになりがちな手順を標準化し、保守・復旧をしやすくする

汎用PC(RTX搭載)で同等の運用を目指すことも可能ですが、監視・更新・ログ収集・故障時の復旧などを“自前で設計”する必要があり、規模が大きくなるほど運用負荷が効いてきます。

7. まとめ

RTX搭載の汎用PCは、性能と価格のバランスが優れ、PoCや室内運用では非常に有力です。一方で、エッジAI端末は「省電力・耐環境・連続稼働・遠隔運用」を前提に設計されており、現場で“止めずに回し続ける”用途では総合的な安心感と運用負担の軽さが価値になります。

PoCや室内の検証:RTX搭載PCが有力(高性能・柔軟・コスパ)

現場での連続稼働:Jetson搭載のエッジAI端末が有力(省電力・耐環境・運用の標準化)

補足:なぜエッジAIでNVIDIAがよく使われるのか(CUDAエコシステム)

エッジAI分野でNVIDIA製品がよく使われる背景には、ハードウェア性能に加え、開発を強力に支える「CUDAエコシステム(開発基盤)」が整っていることがあります。

CUDAエコシステム:並列コンピューティング基盤「CUDA」は、AI/ディープラーニング領域で事実上の標準として広く利用されています。

主要フレームワークとの親和性:TensorFlowやPyTorchなど主要フレームワークがNVIDIA GPUに最適化されており、学習から推論までの移行がしやすい点が強みです。

ライブラリ/SDKの充実:画像認識、映像処理、推論最適化、ロボティクスなど用途別のSDKが豊富で、開発期間とコストの削減につながります。

その結果、学習(サーバ側)と推論(エッジ側)を同じNVIDIA系のスタックでつなぎやすく、運用全体の見通しが立てやすい、というメリットも生まれます。

なお近年は、CUDA Toolkit 13.1で導入された「CUDA Tile(タイルベースのプログラミングモデル)」や、Python向けの「cuTile Python」など、PythonユーザーでもCUDAを扱いやすくする動きも進んでいます。